Yet Another Overview of an AD System

之前写的 An Overview of an AD System, 从技术原理上介绍了各个模块(召回、精排、出价、冷启动等)的基本职责和原理,几年过去了,这部分的认知虽然还没过时,但是经历了更多业务后,对整体的商业化也有一个更全面认知,本文尝试从另一个更系统的角度去理解一个广告系统

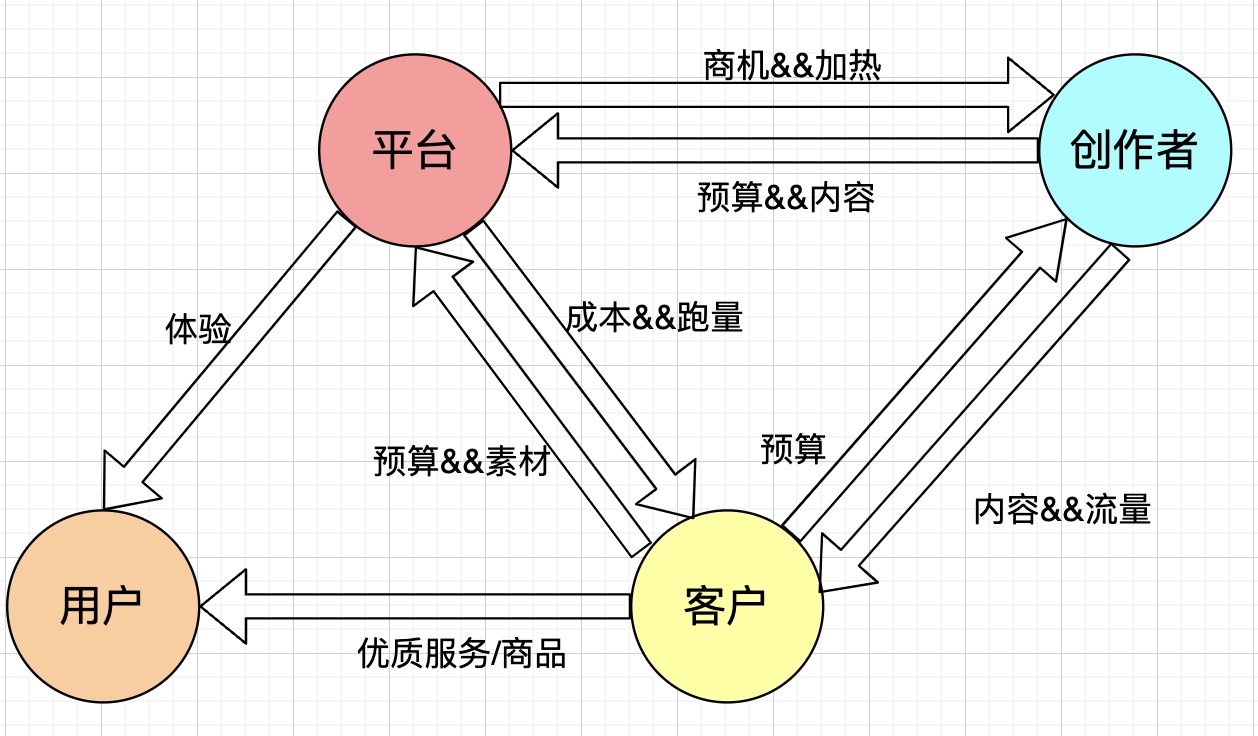

传统认知中的 ad system 一般是三方:广告主 / 代理、平台、用户;但是随着内容平台(如抖音、快手、小红书、bilibili 等)的迅速发展,涌现了越来越多的 UGC 内容,创作者在商业变现中的影响也越来越难被忽视,所以这里基于三方增加了代表创作者的第四方,如下图所示

以上的四方比较复杂的关系,一般是存在于 “一方流量”(参考一方数据的概念)上,即抖音 / 快手 / 小红书 /bilibili 这类有能力搭建自己的一方流量的变现团队,在自家的流量上变现;相较于 “一方流量”,“三方流量” 的场景一般只需要关注客户和平台的关系,典型的就是联盟的场景(穿山甲、优量汇、快手联盟等),对用户侧没有强体验约束,因为本质上联盟就是个倒卖流量的生意,相关技术与一方流量差不多,但是对 C 端的用户体验以及创作者部分基本不怎么关注。

本文重点在一方流量上,下面的内容会根据上图中提到四方依次讨论每一方本身的一些职责、与其他各方的关系,内容会比较发散,祝开卷有益~